Toegepaste statistiek als pijler voor data science

Hoewel data science op veel plaatsen nu in schwung is, werden er in Leiden al lang geleden data science technieken ontwikkeld. Op dit moment combineren Leidse statistici dankzij hun brede expertise de verworvenheden van de statistiek met de nieuwste methoden van statistical en machine learning.

‘Het lijkt of data science iets nieuws is, maar in de toegepaste statistiek ontwikkelen we al jaren data science technieken’, vertelt Jacqueline Meulman, hoogleraar Toegepaste Statistiek op het Mathematisch Instituut. ‘Met het visualiseren van verbanden en het analyseren van grote, complexe databestanden, zijn we in Leiden al zeker 35 jaar bezig’.

SPSS

Uit de jaren ‘90 stamt bijvoorbeeld de eerste bijdrage van Meulmans toenmalige vakgroep aan het welbekende statistische data analyse pakket SPSS, inmiddels een onderdeel van IBM. Het wordt wereldwijd gebruikt door wetenschappers, studenten en het bedrijfsleven. Nog altijd vernieuwen de Leidse statistici hun onderdeel ‘CATEGORIES’ met toevoegingen van de laatste technische ontwikkelingen. De royalties die IBM betaalt, worden weer geïnvesteerd in onderzoek en onderwijsgerelateerde activiteiten.

Complexe data analyse

Een probleem bij het analyseren van grote datasets is de puurheid van de data. ‘Een signaal ontdekken te midden van veel ruis, dat is vaak wat we moeten doen’, vertelt Meulman. Ze geeft als voorbeeld een onderzoek op Metabolomics gebied. Het betrof een onderzoek onder eeneiige tweelingen met als vraag: lijkt het stofwisselingssysteem van de tweelingen meer op elkaar dan door toeval verklaarbaar is? ‘Analyse van bloed en urine leveren grote hoeveelheden data op, maar zulke data zijn altijd complex', legt Meulman uit. ‘De ene helft van een tweeling heeft bijvoorbeeld ’s ochtends ontbeten en de andere niet.’ Ook zijn er veel variabelen in dergelijke bestanden die er helemaal niet toe doen. Meulman en haar collega’s gebruiken de nieuwste technieken om zulke ruisvariabelen eruit te filteren en daardoor gelijkenissen op te sporen.

Statistical learning

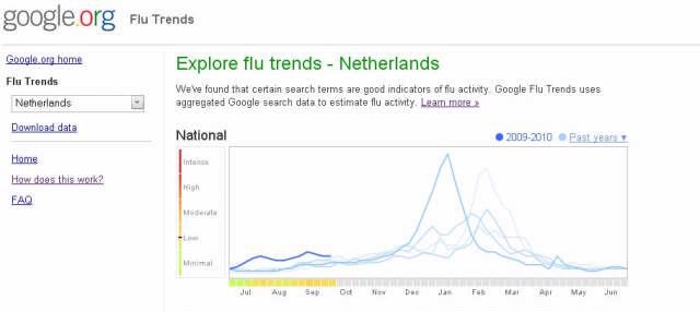

Peter Grünwald, hoogleraar Statistical Learning, doet onderzoek op het raakvlak van statistiek, machine learning en informatietheorie. Kort gezegd ontwikkelt hij methoden om computers statistisch verantwoord data te laten analyseren. Met een voorbeeld maakt hij duidelijk hoe belangrijk dit is. Een paar jaar geleden maakte Google furore: het bedrijf had een griepepidemie voorspeld door te analyseren waar er geografisch veel gezocht werd op woorden zoals koorts, verkoudheid en dergelijke. ‘Dat werkte een of twee keer en daarna niet meer’, zegt Grünwald. ‘Als een programma een patroon ontdekt, moet je laten zien dat het geen toeval is. Daar is echte statistiek voor nodig.’

Reproducibility crisis

Vanuit statistical learning kijken de Leidse statistici ook of de klassieke statistiek verbeterd kan worden met behulp van technieken die in de machine learning – een deelgebied van de informatica - zijn bedacht. ‘Ik ben nu bezig met de reproducibility crisis: veel onderzoek blijkt na herhaling niet dezelfde resultaten te geven’, zegt Grünwald. ‘Dat kan komen doordat een onderzoeker extra experimenten heeft uitgevoerd nadat zijn eerste bevindingen niet significant genoeg bleken om een solide conclusie te kunnen trekken. Dat leidt tot een vertekend beeld: een puur toevallige uitkomst kan ineens betekenisvol lijken. Er zijn statistische methoden om hiervoor te corrigeren, maar die zijn heel ingewikkeld. Met behulp van ideeën uit de machine learning en informatietheorie probeer ik die methodes nu te verbeteren.’