Alles wat we weten leesbaar maken voor computers

We moeten onze data en informatie opslaan op een manier die de computer begrijpt. Dat zegt Barend Mons, hoogleraar Biosemantiek bij het Leids Universitair Medisch Centrum en voorzitter van de High Level Expert Group for the European Open Science Cloud. We praten met hem over FAIR data, knowlets en nanopublicaties.

Barend Mons deed als moleculair bioloog jarenlang onderzoek naar malaria, maar maakte zo’n vijftien jaar geleden de overstap naar bioinformatica. Zijn nieuwe missie: alle kennis en data die we hebben in kaart brengen en opslaan in een computer-vriendelijk format. Op die manier kunnen computers zelf verbanden en patronen gaan signaleren. Om dat te bereiken is niet alleen slimme software en technologie nodig, aldus de hoogleraar, maar vooral ook een andere mindset binnen de academische wereld.

Barend Mons

Computers begrijpen maar weinig van tekst. Hoe komt dat?

‘Taal is een nachtmerrie voor computers. In de wetenschap gebruiken we – net als daarbuiten, trouwens – allerlei termen om hetzelfde begrip mee aan te duiden. Er zijn veel verschillende talen en bovendien gebruiken we graag synoniemen en stijlfiguren. Het menselijk brein kan al die verschillende termen wel plaatsen, wij kunnen bijvoorbeeld begrijpen dat malaria en paludisme dezelfde ziekte zijn. Maar de computer kan daar helemaal niks mee: die ziet geen enkel verband tussen die twee zonder instructies. Toen ik me dat jaren geleden realiseerde, ben ik me gaan bezighouden met biosemantiek, een vakgebied dat probeert om alle termen die we in de biologie voor begrippen en hun onderlinge relaties gebruiken in kaart te brengen op een manier die voor de computer te begrijpen is. Want als we eenmaal een systeem hebben waarin alle kennis op die manier is opgeslagen, een Semantic Web, kunnen we computers op veel slimmere manieren gaan inzetten in de wetenschap.’

Wat is ervoor nodig om kennis toegankelijk te maken voor computers?

‘Het belangrijkste is dat we op een andere manier leren omgaan met data. Want je kunt wel eerst een artikel publiceren en dat vervolgens omzetten naar een format waar de computer iets mee kan, maar het is veel efficiënter om onze bevindingen van het begin af aan op die manier te publiceren. Daarbij is het belangrijk dat data door anderen kan worden hergebruikt. Daar hebben we de FAIR-principes voor bedacht: alle wetenschappelijke data zou Findable, Accessible, Interoperable en Reusable moeten zijn voor mensen én computers. De essentie van FAIR is: refereer nergens, geen celletje of kolom in je database, naar iets wat de computer niet begrijpt.’

Samen met uw onderzoeksgroep heeft u een belangrijke rol gespeeld in het ontwikkelen van de nanopublicaties. Wat zijn dat precies?

‘Het is een manier om de kleinste informatie-units te publiceren. Een nanopublicatie is de kleinst denkbare betekenisvolle publicatie: een simpele, voor de computer te begrijpen bewering, van het formaat ‘a doet iets met b’. Bijvoorbeeld de zin ‘malaria wordt overgebracht door muskieten’. Zulke beweringen kun je als volledige publicaties behandelen door er informatie over de herkomst aan te hangen: auteur, datum, wel of niet peer reviewed, enzovoorts.’

Knowlets

En wat kunnen we met die nanopublicaties doen?

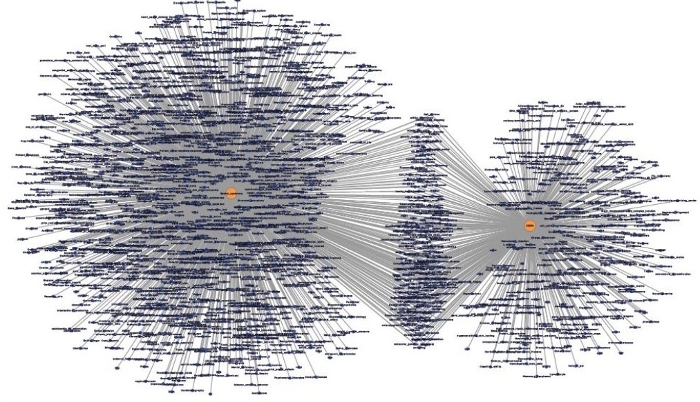

‘Stel je eens voor dat we het hele Explicitome - oftewel, alle kennis die nu is opgeslagen in databases en wetenschappelijke artikelen - kunnen omzetten in nanopublicaties. Omdat de computer die kan lezen, is hij in staat ze te ordenen in een systeem van knowlets: een soort clusters die alle beweringen bevatten die over een concept zijn gedaan met een ‘gewicht’ eraan. Inmiddels hebben we voor de levenswetenschappen zo’n systeem ontwikkeld. Ieder concept waar we het over hebben - ieder gen, iedere ziekte, ieder molecuul - heeft een eigen knowlet; daarmee kunnen we precies zien hoe al die verschillende concepten met elkaar samenhangen. En door de grote hoeveelheid data en kennis die in dat systeem is opgeslagen, gaan we verbanden zien waarvan we niet wisten dat ze bestonden. Of, beter nog: de computer gaat die verbanden zelf zien, en stelt ons daarvan op de hoogte. Bijvoorbeeld dat een bepaald gen en een bepaalde ziekte waarschijnlijk iets met elkaar te maken hebben. Dan kunnen wij daar vervolgens verder onderzoek naar doen.’

Maar alle kennis die we hebben vangen in zo’n systeem, dat lijkt me nogal een klus.

‘Ja, voor de levenswetenschappen gaat het op dit moment om ongeveer drie miljoen knowlets en zo’n 1014 nanopublicaties. We zijn er nog lang niet, maar de belangrijkste onderliggende problemen hebben we inmiddels wel opgelost. We hebben bijvoorbeeld een systeem ontwikkeld waarmee we wetenschappelijke artikelen kunnen omzetten in nanopublicaties. Met behulp van text mining laten we de computer artikelen scannen en er nanopublicaties uit distilleren. Op die manier zuigen we al die wetenschappelijke publicaties leeg en zetten we alles wat we nog niet wisten in een database, die voor iedereen toegankelijk is. Open Access hebben we voor dit proces niet eens meer nodig.’

Mag dat allemaal zomaar?

‘Ja, want technisch is een nanopublicatie niets anders dan een citatie. Je leest een artikel, citeert daar een zin uit en verwijst daarbij netjes terug naar de bron. Het enige verschil is dat we die citaties nu in een formaat zetten dat ook voor de computer leesbaar is. En natuurlijk fronsen de Elseviers van deze wereld er even hun wenkbrauwen bij - daar gaat hun firewall - maar uiteindelijk hebben ze er zelf ook baat bij. Want zo’n nanopublicatie is ook een mooie advertentie voor het achterliggende artikel. Inmiddels beginnen de uitgevers dat zelf ook wel in te zien.’

Maar hoe zit het met de onderzoekers zelf - zijn die er wel klaar voor om hun data te delen?

‘Als je dat aan onderzoekers vraagt, zegt 98% ja. Maar als je vraagt of ze het ook doen, is dat nog maar 60%. Er zijn een paar enorme hobbels voor het delen van data. Ten eerste ontbreekt vaak de expertise: het FAIR formatteren van data is niet zo ingewikkeld, maar je moet wel weten hoe het moet. In de komende jaren moeten we mensen opleiden die onderzoekers daarbij gaan assisteren. We organiseren ook BYOD-workshops (Bring Your Own Data), waarbij we onderzoekers helpen hun eigen dataset FAIR te maken. Maar misschien wel het belangrijkste obstakel voor het delen van data, is dat het onderzoekers simpelweg te weinig oplevert.’

Omdat ze toch voornamelijk beoordeeld worden op de artikelen die ze publiceren?

‘Precies. We beoordelen wetenschappers nog steeds op criteria uit de negentiende eeuw, en dat slaat echt helemaal nergens meer op. Vandaag de dag vormen artikelen niet meer het centrum van wetenschappelijke communicatie: in hoeverre je als onderzoeker data produceert en deelt, is veel belangrijker. Maar sommige wetenschappers willen liever dat alles bij het oude blijft. Dan zeg ik: als je nu nog denkt dat je een voorsprong kunt houden door bovenop je data te gaan zitten, ben je echt over een paar jaar uitgerangeerd. Dan maak je straks geen doorbraken meer; al het laaghangende fruit is al geplukt. En nu, na vijftien jaar knokken tegen het establishment, begint er eindelijk een verandering te komen. Ook in het buitenland zie je dat de principes van FAIR steeds meer tot standaarden leiden die worden gebruikt.’

Gaan we daar buiten de academische wereld ook iets van merken?

‘Jazeker. Sommige ziekenhuizen hebben bijvoorbeeld al FAIR datastations, waarin ze grote hoeveelheden data gebruiken om hun eigen zorg te verbeteren, of de effecten van medicijnen te analyseren. Samen met een aantal universiteiten en academische ziekenhuizen zijn we dat nu aan het vertalen naar het niveau van smartphones: de Personal Health Train. Dat is een systeem waarmee straks je persoonlijke gezondheidsdata wordt opgeslagen in een kluisje op je smartphone, in de vorm van FAIR data. Als er iemand aanklopt die naar je gegevens wil kijken - dat kan Albert Heijn zijn, maar ook bijvoorbeeld je huisarts, of een patiëntenfederatie - bepaal je zelf wie toegang krijgt en wie niet. Dat is een veiligere manier van data opslaan dan hoe het op dit moment geregeld is. Bovendien is het een mooie oplossing voor dat vreselijke elektronisch patiëntendossier, waarvoor ziekenhuizen nu allerlei verschillende systemen gebruiken die onderling niet kunnen communiceren. ’

Wat is er met die Personal Health Train allemaal mogelijk?

‘De apotheker kan bijvoorbeeld ingrijpen, als je een bepaald gen hebt dat niet goed samengaat met een medicijn dat een arts je heeft voorgeschreven. Of een patiëntenfederatie kan met behulp van grote hoeveelheden data onderzoek doen naar de bijwerkingen van een bepaald medicijn, of naar hoe gezond bepaalde voedingsmiddelen eigenlijk zijn. De mogelijkheden zijn ongekend. De supercomputer van de toekomst is niet een kathedraal vol computers, maar zeven miljard smartphones.’

Barend Mons begon zijn carrière als moleculair bioloog en promoveerde aan de Universiteit Leiden. Na jarenlang onderzoek te hebben gedaan naar malaria stapte hij over naar wetenschapsmanagement. Hij werkte bij het Research Directorate van de Europese Commissie en bij NWO. Daarna ging Mons opnieuw de wetenschap in; hij werkte bij de vakgroep Medische Informatica van het Erasmus Medisch Centrum en is sinds 2013 hoogleraar Biosemantiek bij het Leids Universitair Medisch Centrum. Daarnaast is hij Head of Node van ELIXIR-NL bij het Dutch Techcentre for Life Sciences, en Integrator Life Sciences bij het Netherlands eScience Center. Mons is de initiatiefnemer van FAIR en werd in 2015 benoemd tot voorzitter van de High Level Expert Group ‘European Open Science Cloud’ van de EU.

(JvdB)